Как проверить индексацию сайта в Яндекс, Google и других поисковых системах. В статье мы рассмотрим способы проверки индексирования сайта, ситуации, когда страницы сайта не попадают в индекс и варианты решения этой проблемы.

В базу поисковых систем попадают не все сайты и их страницы, и причин тому много. А если ваш ресурс не обнаружен в индексе, значит, и пользователь не найдёт его через поисковик. Это грозит потерей ценного трафика и потенциальных клиентов.

Рассказываем, как контролировать и проверять индексацию сайта, а при необходимости запретить или ускорить.

Зачем проверять и контролировать индексацию

Индексацией называется процесс, когда поисковые роботы исследуют страницы вашего сайта, переходя с одной на другую, и передают данные в базу поисковиков. Только после этого ресурс появляется на определённой позиции в поисковой выдаче в ответ на запрос пользователя.

Зачем проверять, проиндексирован ли ресурс:

-

Для повышения видимости страниц в поисковой выдаче

Если страница вашего сайта попадает в индекс, пользователь сможет найти её через поиск и перейти. Для этого каждую веб-страницу ресурса оптимизируют под определённый перечень поисковых запросов, по которым она стремится обойти конкурентов в выдаче поиска. Это повышает её видимость для пользователей.

-

Для обновления контента

Поисковики время от времени обновляют индекс с целью актуализации выдачи. Вебмастера тоже стремятся оптимизировать уже существующий контент, сделать более ценным для пользователей. Но если страницы нет в индексе, то актуализация контента, размещение ссылок на другие ресурсы и многие другие действия – бессмысленны.

-

Для выявления проблем с сайтом

Обнаруженное при проверке изменение процента проиндексированных страниц может говорить о различных проблемах, например, о блокировке сайта поисковыми системами. А ещё часто индексации препятствует неверно составленный файл robots.txt или тег noindex.

Кроме того, проверка нужна, чтобы контролировать действия поисковых систем. Ведь робот, придя на сайт, видит всю его подноготную. И если его вовремя не прервать, он будет проходить все страницы без разбора, а значит, в поиске могут оказаться и те из них, которые вам совсем не нужно выставлять на всеобщее обозрение.

А ещё ресурсы робота ограничены, за определённый период он может обойти только конкретное количество страниц (краулинговый бюджет). Если ваш ресурс многостраничный, высока вероятность, что робот пройдёт совсем не те веб-страницы, которые вам нужны в поиске, а важные оставит на потом.

Поэтому индексирование требует управления и контроля. Как это сделать — рассказываем далее.

Как проверить индексацию через панели вебмастеров

Яндекс.Вебмастер и Google Search Console – главные инструменты вебмастеров, которые выдают подробные сведения об индексировании, причём бесплатно и достоверно. Учитывайте, что они доступны вам, только если вы владелец сайта, сторонние ресурсы по ним не проверить.

Яндекс.Вебмастер

Общие сведения об индексировании смотрите на главной странице панели — во вкладке «Сводка». Здесь отражены, сколько и какие страницы попали в поиск, история обхода, клики в поиске, наличие проблем на сайте, его индекс качества (ИКС).

Есть и отдельный раздел под названием «Индексирование», в котором собран комплекс отчётов и инструментов:

-

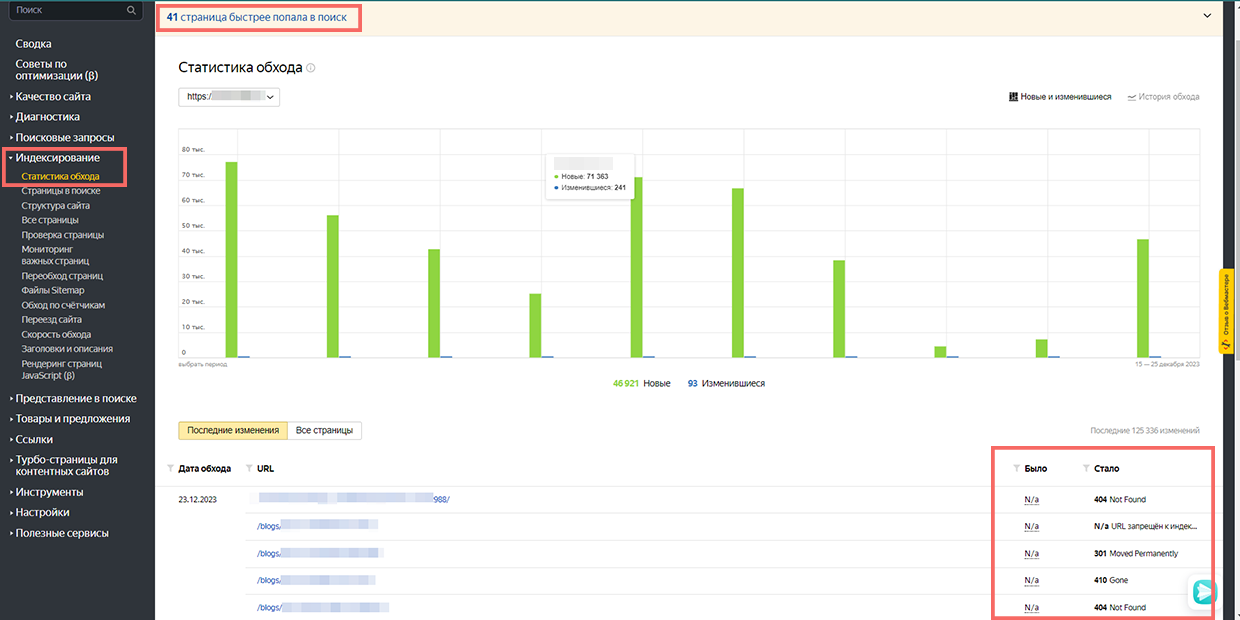

«Статистика обхода»

Раздел «Индексирование» в Яндекс.Вебмастере

Здесь приведена информация о сканировании роботом веб-страниц и о проблемах, с которыми он столкнулся. Вы можете посмотреть отчёт по последним событиям или по всем просканированным веб-страницам, начиная с последних. Обращайте внимание на код ответа сервера: если всё хорошо, он будет 200 ОК. Если вы удалили веб-страницу, увидите ошибку 404 Not Found. У правильно работающего ресурса не должно быть ответов 500.

-

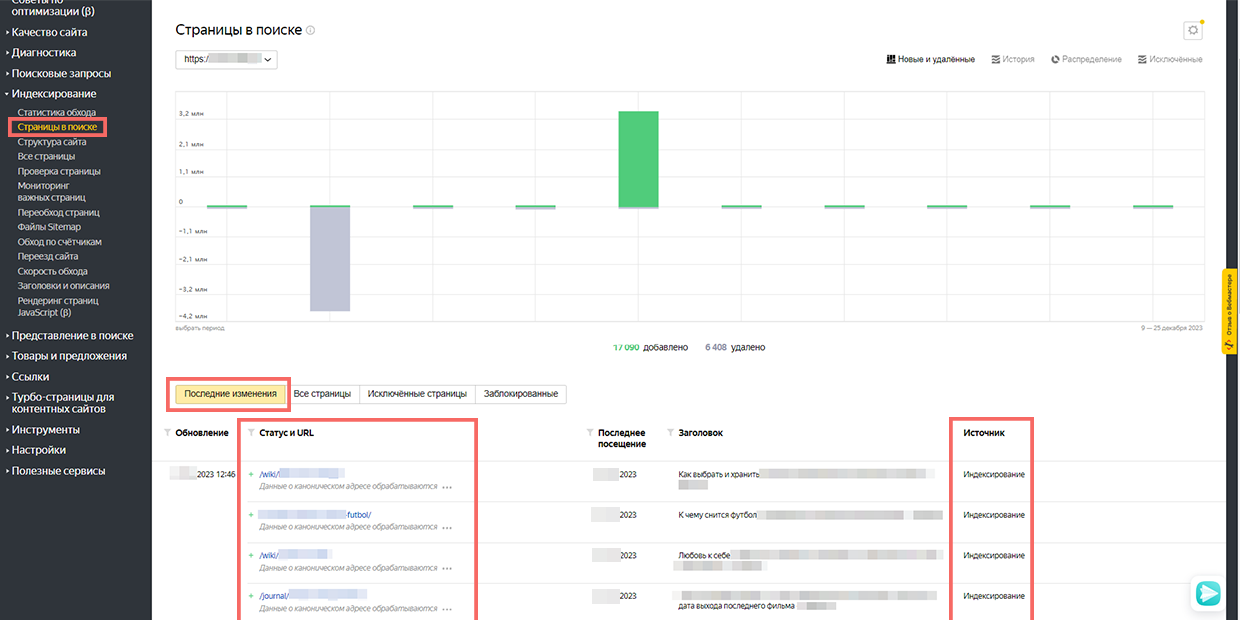

«Страницы в поиске»

«Последние изменения» показывают текущие сведения о URL, которые участвуют в поисковой выдаче Яндекса

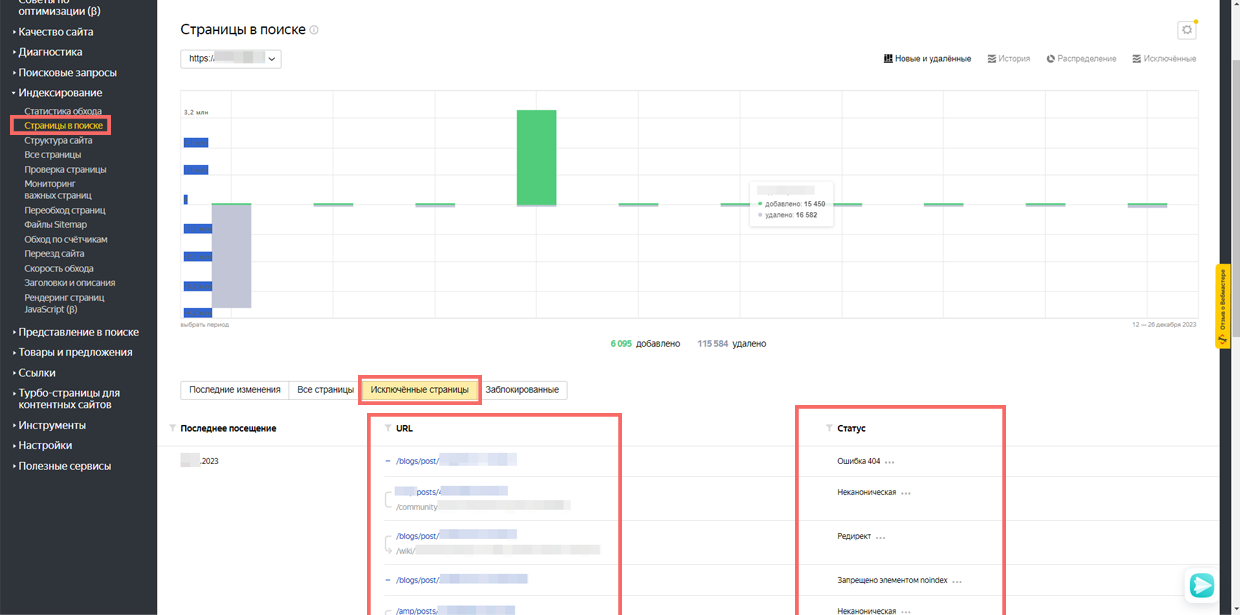

«Исключённые страницы» показывают URL, выпавшие из индекса.

Во вкладке можно посмотреть проиндексированные страницы. В разделе «Последние изменения» вы получите текущие сведения о URL, которые участвуют в поисковой выдаче Яндекса. А в «Исключённых страницах» показаны URL, выпавшие из индекса, и причины этого.

-

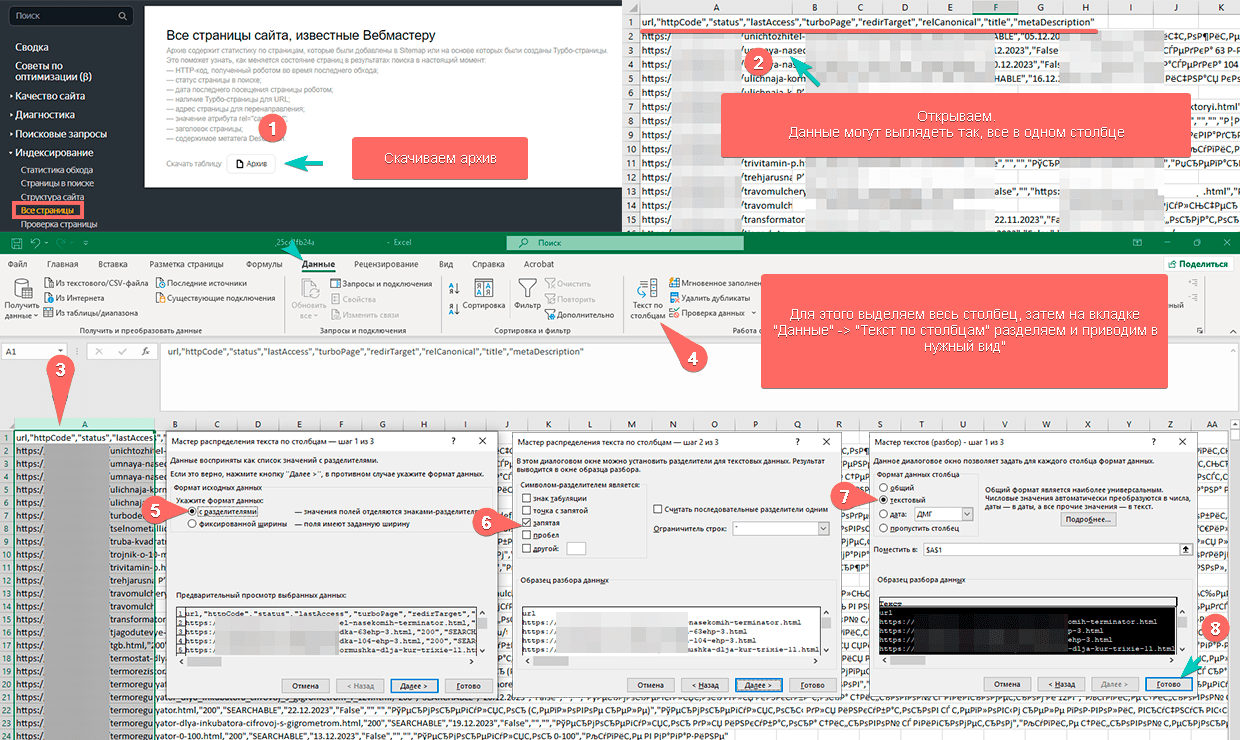

«Все страницы»

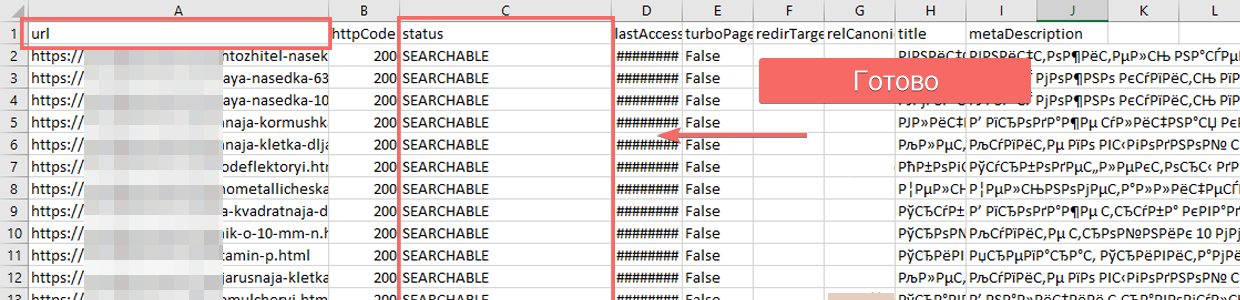

Выгрузка таблицы со сведениями об индексации страниц, присутствующих в файле sitemap

Отметка "Searchable" напротив URL показывает, что страница в поиске.

Из этого раздела можно выгрузить таблицу со сведениями об индексации страниц, присутствующих в файле sitemap. По таблице считывать данные не очень удобно, но если вы видите напротив URL отметку searchable, значит, она в поиске.

-

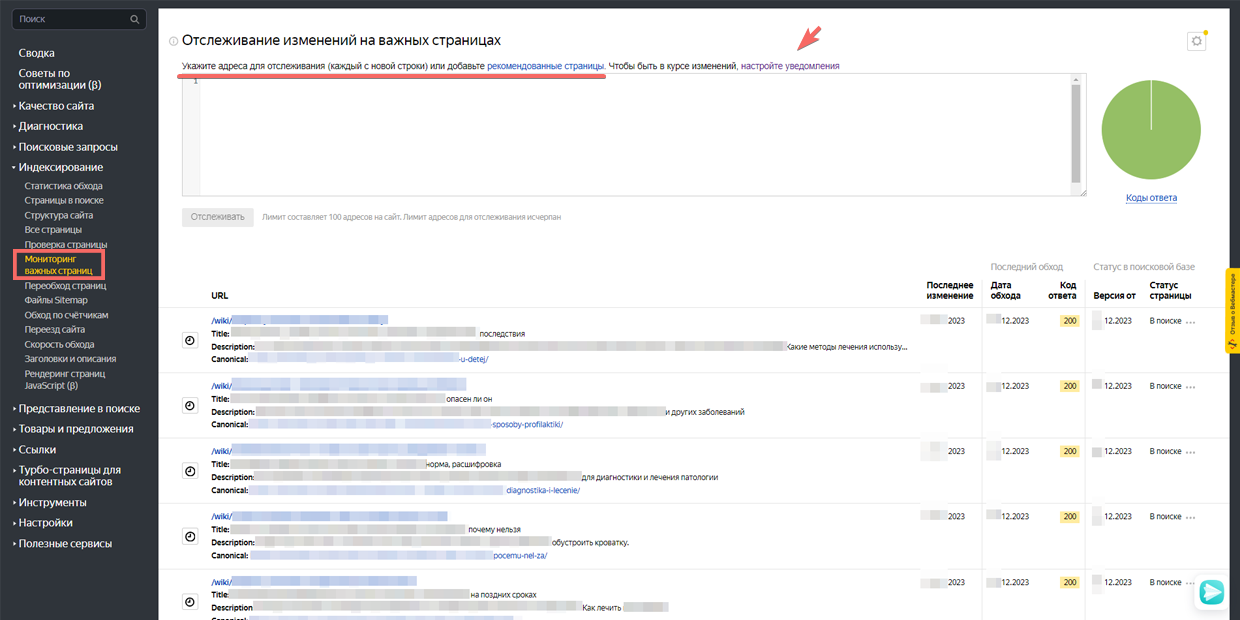

«Мониторинг важных страниц»

Мониторинг важных страниц в Яндекс.Вебмастере. Позволяет внести собственный список адресов для отслеживания индексирования.

Ещё одна нужная опция, которая позволяет составить список до 100 адресов для отслеживания их индексирования. Так отпадает необходимость искать определённые URL в перечне проиндексированных. Если настроите уведомления, поисковик будет информировать вас об изменениях в веб-страницах из списка.

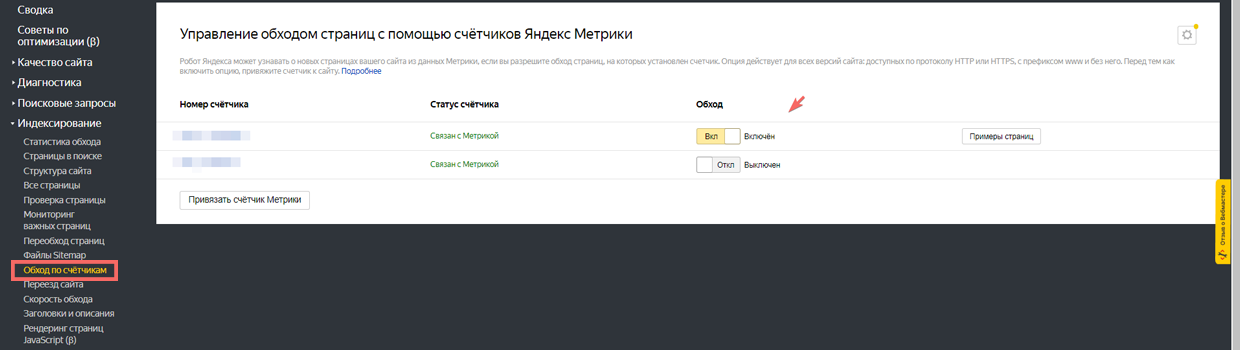

А если хотите, чтобы Яндекс чаще сканировал ваш сайт и новые страницы, активируйте обход по счётчикам в этом же разделе. Для этого ресурс должен быть сопряжён со счётчиком Метрики.

Активация обхода страниц с помощью счетчиков Яндекс Метрики

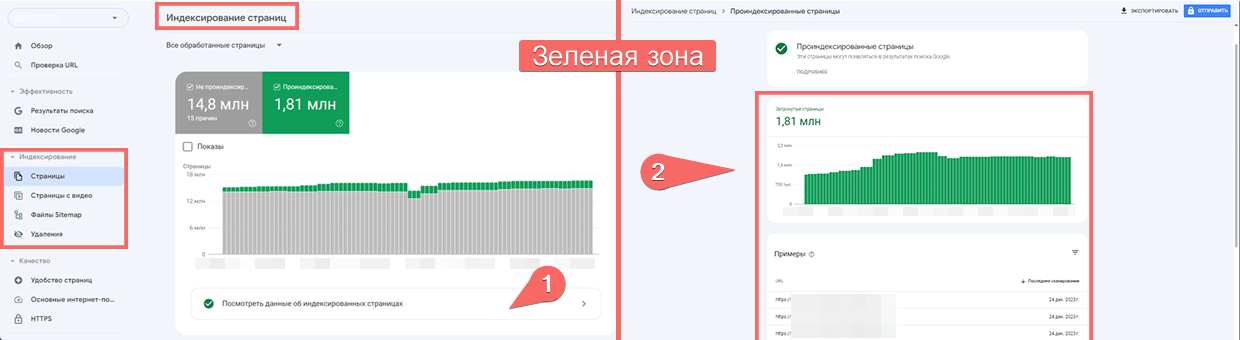

Google Search Console

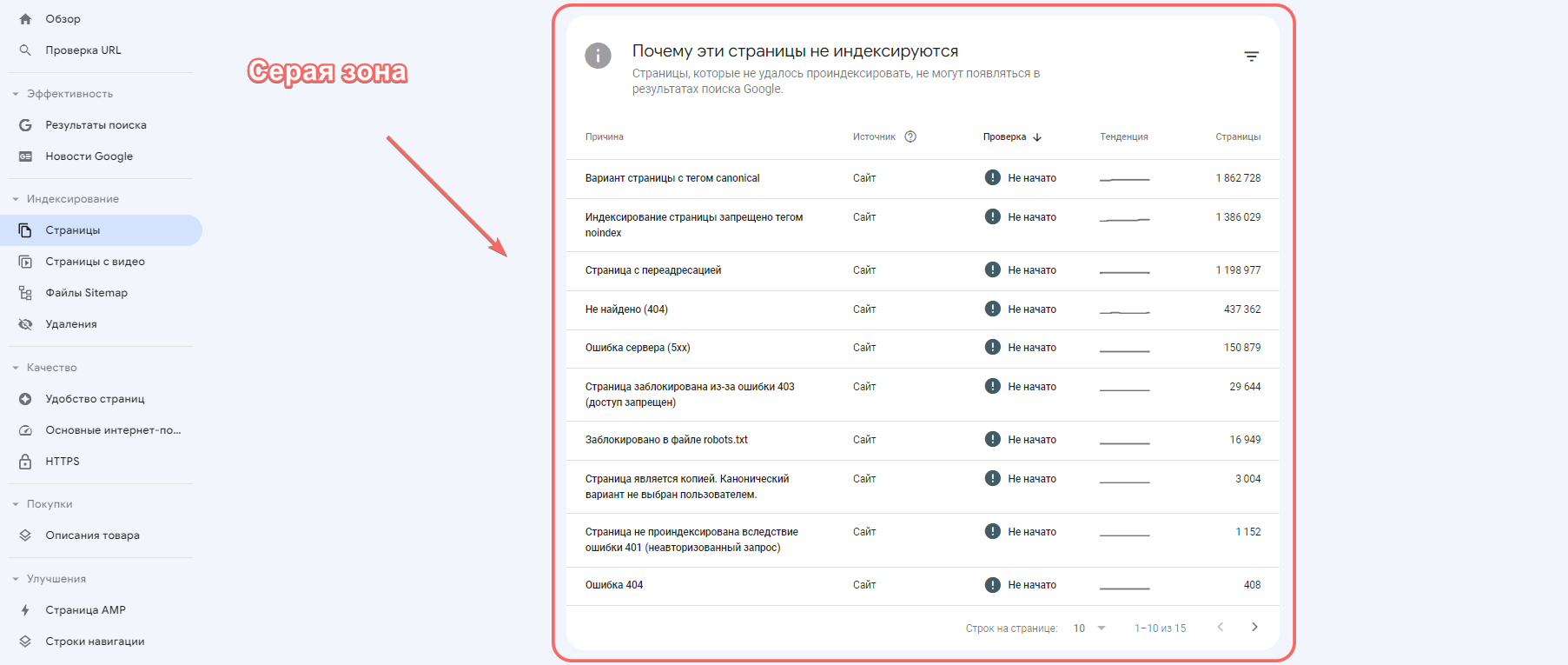

Узнать об индексации сайта в поисковике Google тоже можно с помощью панели для вебмастеров — в разделе «Покрытие». Все страницы сайта здесь разделены на четыре категории:

-

Без ошибок. Зелёная зона. Желательно, чтобы все важные URL попали именно в этот список.

-

С ошибками. Красная зона.

-

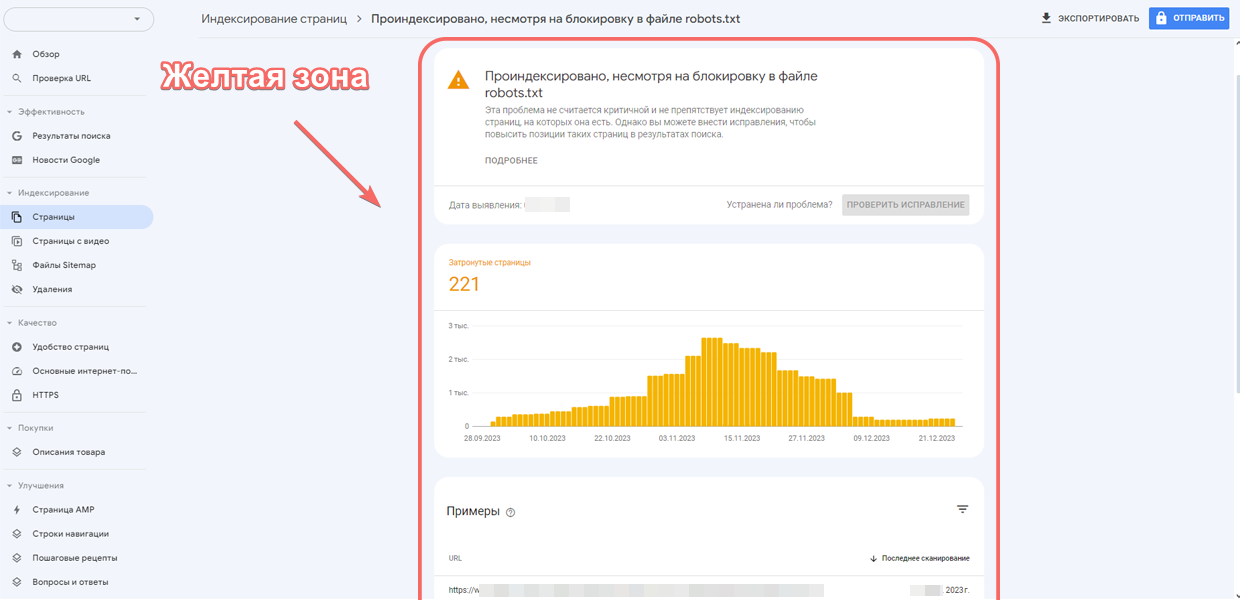

Без ошибок, но с предупреждениями. Жёлтая зона.

-

Исключённые из поиска. Серая зона.

Визуализирует данные график.

Google Search Console: Зеленая зона - без ошибок

Google Search Console: Серая зона - исключена из поиска

Google Search Console: Желтая зона - без ошибок, с предупреждениями

Если число страниц вашего ресурса соответствует количеству URL в зелёной и жёлтой зоне, значит с индексацией всё в порядке. Отметим, что в категорию «Жёлтая зона» часто попадают страницы, запрещённые robots.txt. Ниже графика представлены сведения, почему страницы были отнесены к той или иной группе.

Как проверить индексацию с помощью расширений для браузеров и букмарклетов

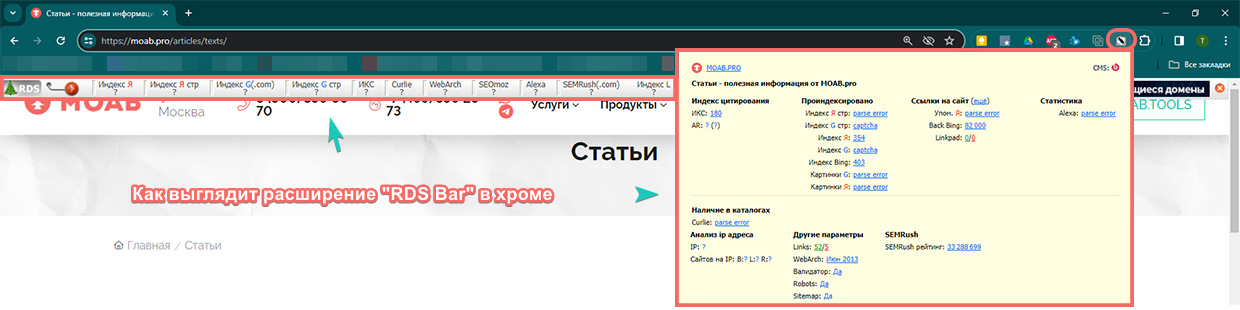

Автоматизируют проверку специальные плагины для браузера, которые агрегируют сведения о странице и ресурсе в целом, включая данные об индексировании.

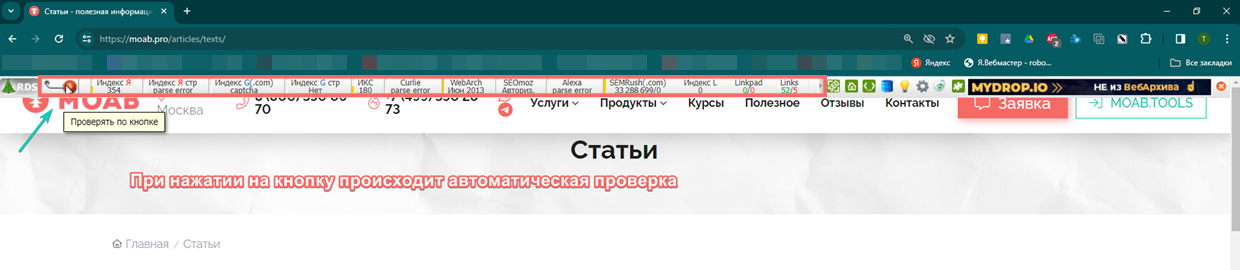

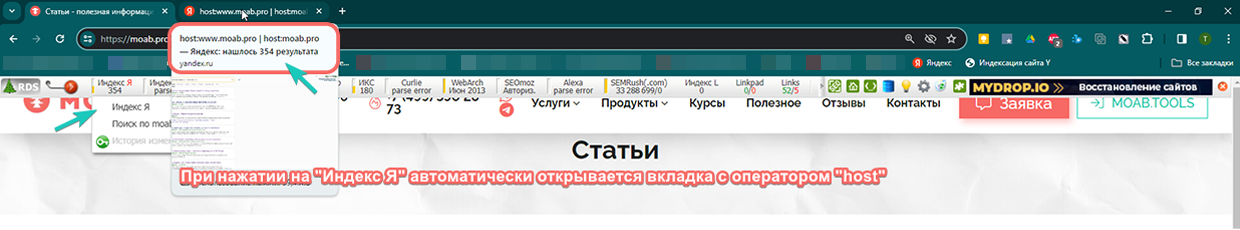

Одно из самых популярных браузерных расширений — RDS Bar, которым пользуется почти каждый SEO-специалист. Плагин может быть установлен на Хром, Оперу, Firefox. Запустите RDS Bar на нужной веб-странице и дождитесь загрузки данных. Если нажмёте на текст статуса индексирования, будет открыто окно поисковой системы с уже сформированным запросом через поискового оператора site. Напомним, этот оператор «site:»+URL позволяет определить примерное число веб-страниц в поиске, которые начинаются с обозначенного URL.

Браузерное расширение RDS Bar. Вид в браузере Chrome

Браузерное расширение RDS Bar. Автоматическая проверка и вывод данных в ячейках при нажатии на кнопку RDS.

Браузерное расширение RDS Bar. Автоматическое открытие вкладок с операторами при нажатии на кнопку.

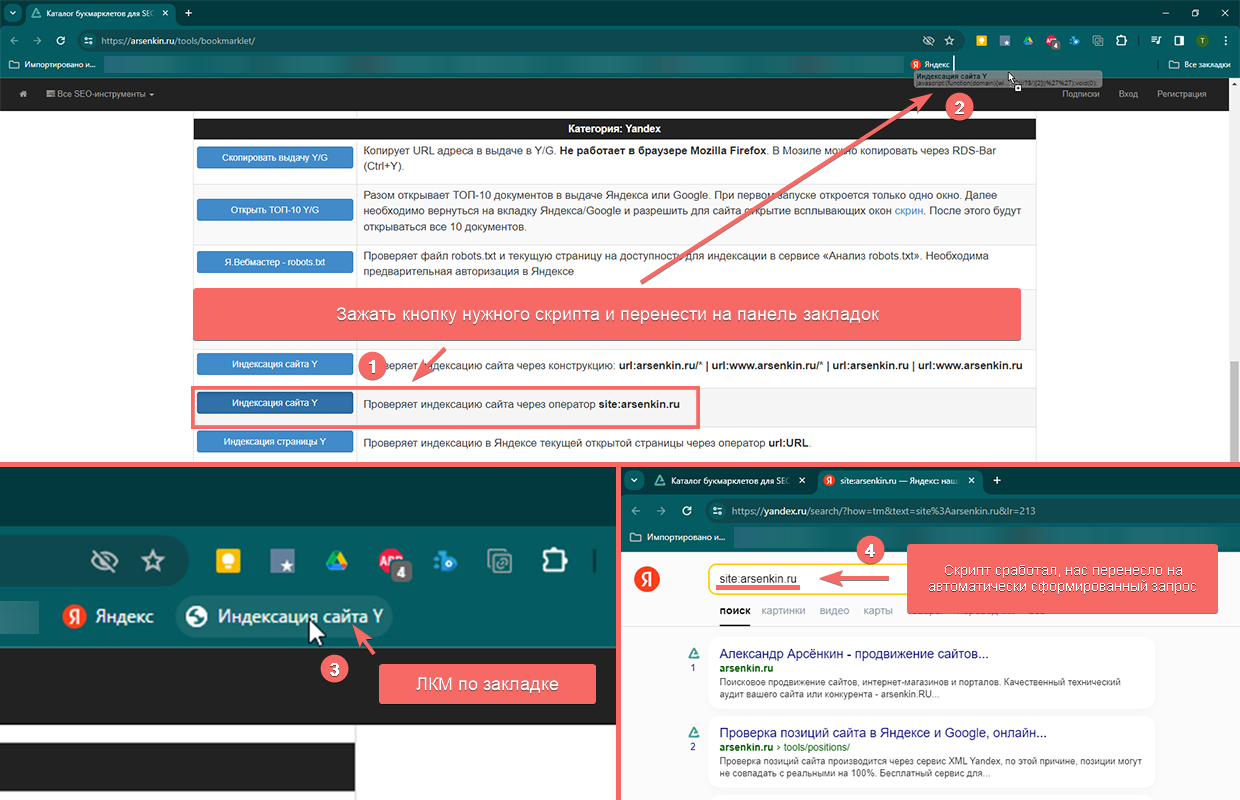

Альтернативный способ — использование bookmarklet. С его помощью автоматом формируется ссылка с поисковым запросом через оператор site.

Букмарклет — это скрипт-программа с оформлением как javascript: URL, который сохраняется как браузерная закладка. Большой список bookmarklet можно найти здесь. Зажмите кнопку нужного скрипта и перетащите её на панель закладок браузера. Когда вы впоследствии будете находиться на нужной странице ресурса, нажмите на закладку, которая перенесёт вас в браузер с уже сформированным запросом.

Пример работы скрипт-программы букмарклет.

Почему сайт может не индексироваться

Хорошо, если все желаемые URL сайта проиндексированы, их число и количество страниц в поиске плюс-минус одинаковое. Но так бывает не всегда, препятствием для индексации могут быть следующие причины:

-

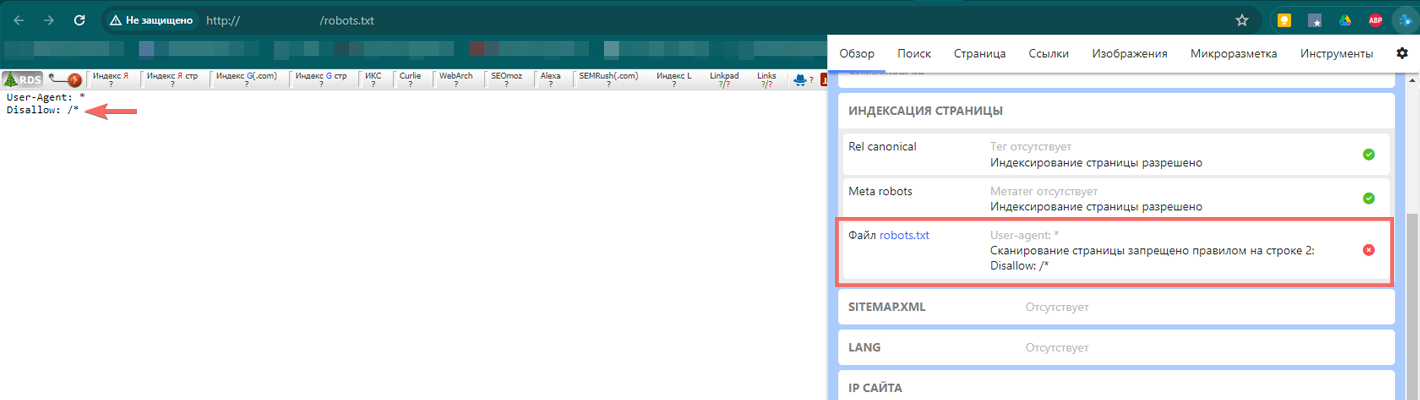

Некорректно составленный файл robots.txt. Это текстовый документ с параметрами индексирования. Он запрещает или разрешает поисковым роботам индексацию страниц. Если директивы используются неправильно, весь сайт или конкретные его веб-страницы могут быть закрыты от индексирования. Периодически проверяйте файл — все ли нужные страницы разрешены для сканирования.

Анализ файла robots.txt в Яндекс Вебмастере

Пример, когда сканирование страницы запрещено в файле robots.txt

-

Отсутствие карты сайта (файла sitemap.xml). Документ находится в корневом каталоге сайта и содержит ссылки на все страницы. Это оптимизирует сканирование контента поисковыми роботами. Добавляйте сюда только те страницы, которые хотите видеть в поиске.

-

Проблемы с мета-тегами. Из-за отсутствия title и description или их повторений на разных страницах поисковики не могут распознать контент. Решается проблема добавлением уникальных мета-тегов на каждую страницу ресурса.

-

Дублирование контента. Если на сайте есть страницы с повторяющимся или очень схожим содержанием, некоторые из них могут не попасть в индекс. Нужно избавиться от «копий» или объединить контент на одной странице.

-

Низкое качество контента. Малополезными для пользователей могут быть признаны страницы с неуникальным, коротким контентом или не отвечающим поисковым запросам. В эту группу могут также попасть материалы, сгенерированные искусственным интеллектом.

-

Новый сайт. Индексирование нового ресурса требует времени, поэтому в этом случае придётся подождать.

-

Приватные настройки. В некоторых CMS, например, WordPress и MegaGroup, через админку можно скрыть страницы от индексирования, при этом настройка может быть выставлена по умолчанию.

-

Тег «noindex». Страницы могут быть закрыты для индексации в коде с помощью мета-тега name="robots" content="noindex, nofollow" />. Решение – убрать мета-тег или подкорректировать на «index» и «follow».

Это не весь перечень проблем, которые требуют анализа. Иногда страницы не индексируются из-за ошибок сканирования, блокировки ресурса в файле .htaccess, низкого uptime хостинга, медленной скорости загрузки сайта, блокировок и фильтров поисковых систем.

Даже если страница попала в индекс, нет никакой гарантии, что там она останется навсегда. Поэтому время от времени проводите проверки.

Как контролировать индексацию

Чтобы контролировать работу поисковых роботов и добиться лучших результатов индексирования, придерживайтесь следующих рекомендаций:

-

Внесите сайт в Яндекс.Вебмастер и Google Search Console. Так вы из первых уст будете узнавать о количестве проиндексированных страниц и другие актуальные данные об индексации и техническом состоянии ресурса.

-

Создайте карту сайта в формате xml. В WordPress это можно сделать с помощью плагинов, например, Google XML Sitemaps. А ещё можно воспользоваться онлайн-сервисами, например, Gensitemap и XML-Sitemaps.

-

Создание файла robots.txt. С его помощью разрешайте или запрещайте роботу обход конкретных страниц ресурса.

-

Используйте опцию ручного сканирования. Запускайте «Переобход страниц», если нужные вам веб-страницы долго не попадают в индекс, или вы актуализировали контент.

А ещё контролируйте актуальность контента, периодически внося изменения.

Как ускорить индексацию сайта

Поисковые роботы активнее сканируют сайты, на которых появляется что-то новое. Поэтому чем больше материалов вы публикуете, тем быстрее они будут попадать в индекс.

Следите, чтобы на сайте не было ошибок, повторов контента, малополезных страниц. Они не только снижают скорость индексирования, но и расходуют краулинговый бюджет. В результате поисковые алгоритмы сосредотачиваются на ошибках и низкокачественном контенте, вместо того, чтобы заниматься важными для вас URL.

Ускорение индексирования – комплексные работы, которые требуют индивидуального подхода, поскольку должны учитывать специфику и характеристики конкретного сайта и сервера, на котором он расположен. Мы приведём общие рекомендации:

-

Избавляйтесь от ошибок, повторов и «малоценных» страниц.

-

Настройте перелинковку. К каждой веб-странице должны вести конкретная ссылка с правильными анкорами и околоссылочным текстом. Чтобы ускорить индексирование новых страниц, публикуйте ссылки на них на главной странице сайта, которую поисковые роботы посещают чаще остальных. Ускорить процесс способны также репосты статей в соцсетях.

-

Настройте автообновление карты сайта. Все новые URL должны заноситься в sitemap, а удаленные – извлекаться из карты.

-

Повышайте скорость загрузки страниц. Чем быстрее они будут загружаться, тем лучше. За ориентир можно взять усреднённые показатели скорости конкурентов.

Но прежде всего ваш сайт должен быть удобен и полезен пользователю. Понятная и простая навигация, грамотная перелинковка и «сарафанное радио» в сети может положительно сказаться на индексировании сайта.